切换主题

Hibernate 6 简介

版本 6.3.1.最终版

目录

[toc]

前言

Hibernate 6 是对世界上最流行且功能丰富的 ORM 解决方案的重大重新设计。重新设计几乎涉及 Hibernate 的每个子系统,包括 API、映射注释和查询语言。这个新的 Hibernate 更强大、更健壮、类型更安全。

有了如此多的改进,很难概括这项工作的意义。但以下一般主题很突出。休眠6:

- 最终利用过去十年关系数据库的进步,更新查询语言以支持现代 SQL 方言中的大量新结构,

- 在不同的数据库中表现出更加一致的行为,极大地提高了可移植性,并从与方言无关的代码中生成更高质量的 DDL,

- 通过在访问数据库之前更严格地验证查询来改进错误报告,

- 提高了 O/R 映射注释的类型安全性,澄清了 API、SPI 和内部实现的分离,并修复了一些长期存在的架构缺陷,

- 删除或弃用旧版 API,为未来的发展奠定基础,以及

- 更好地利用 Javadoc,为开发人员提供更多信息。

Hibernate 6 和 Hibernate Reactive 现在是 Quarkus 3 的核心组件,Quarkus 3 是 Java 云原生开发最令人兴奋的新环境,并且 Hibernate 仍然是几乎每个主要 Java 框架或服务器的持久性解决方案选择。

不幸的是,Hibernate 6 中的更改已经废弃了书籍、博客文章和 stackoverflow 上提供的有关 Hibernate 的大部分信息。

本指南是对当前功能集和建议用法的最新高级讨论。它并不试图涵盖所有功能,应与其他文档结合使用:

- Hibernate 广泛的Javadoc,

- Hibernate 查询语言指南,以及

- Hibernate用户指南。

| Hibernate 用户指南包含 Hibernate 大多数方面的详细讨论。但要涵盖的信息如此之多,可读性很难实现,因此作为参考最有用。如有必要,我们将提供用户指南相关部分的链接。 | |

|---|---|

1. 简介

Hibernate 通常被描述为一个库,可以轻松地将 Java 类映射到关系数据库表。但这种表述并没有充分体现关系数据本身所发挥的核心作用。所以更好的描述可能是:

Hibernate 使关系数据以****自然且类型安全的形式对用 Java 编写的程序可见,

- 可以轻松编写复杂的查询并处理其结果,

- 让程序轻松地将内存中的更改与数据库同步,尊重事务的 ACID 属性,以及

- 允许在编写基本持久性逻辑后进行性能优化。

这里关系数据是焦点,还有类型安全的重要性。对象/关系映射(ORM)的目标是消除脆弱和非类型安全的代码,并使大型程序从长远来看更易于维护。

ORM 使开发人员无需手动编写繁琐、重复且脆弱的代码来将对象图展平为数据库表,并从平面 SQL 查询结果集重建对象图,从而消除了持久性带来的痛苦。更好的是,在编写了基本的持久性逻辑之后,ORM 使以后调整性能变得更加容易。

| 一个长期存在的问题是:我应该使用 ORM 还是纯 SQL?答案通常是:两者都使用。JPA 和 Hibernate 被设计为与手写 SQL 结合使用。您会看到,大多数具有重要数据访问逻辑的程序至少会在某些地方受益于 ORM 的使用。但是,如果 Hibernate 使事情变得更加困难,对于某些特别棘手的数据访问逻辑,唯一明智的做法就是使用更适合该问题的东西!仅仅因为您使用 Hibernate 来实现持久性并不意味着您必须将它用于所有事情。 | |

|---|---|

开发人员经常询问 Hibernate 和 JPA 之间的关系,因此让我们简单回顾一下历史。

1.1. Hibernate 和 JPA

Hibernate 是Java(现在的Jakarta)持久性 API或 JPA背后的灵感来源,并且包含该规范最新版本的完整实现。

Hibernate 和 JPA 的早期历史

Hibernate 项目始于 2001 年,当时 Gavin King 对 EJB 2 中的 Entity Beans 的挫败感爆发了。它很快超越了其他开源和商业竞争者,成为最流行的 Java 持久性解决方案,与Christian Bauer 合着的*《Hibernate in Action 》一书是一本有影响力的畅销书。*

2004 年,Gavin 和 Christian 加入了一家名为 JBoss 的小型初创公司,其他早期 Hibernate 贡献者很快也加入了进来:Max Rydahl Andersen、Emmanuel Bernard、Steve Ebersole 和 Sanne Grinovero。

不久之后,Gavin 加入了 EJB 3 专家组,并说服该组弃用 Entity Beans,转而采用模仿 Hibernate 的全新持久性 API。后来,TopLink 团队的成员也参与进来,Java Persistence API 在 Linda Demichiel 的领导下,主要是 Sun、JBoss、Oracle 和 Sybase 之间的协作而发展起来。

在这二十年里,许多人才为 Hibernate 的发展做出了贡献。我们都特别感谢史蒂夫,自从加文退后专注于其他工作以来,他领导了该项目多年。

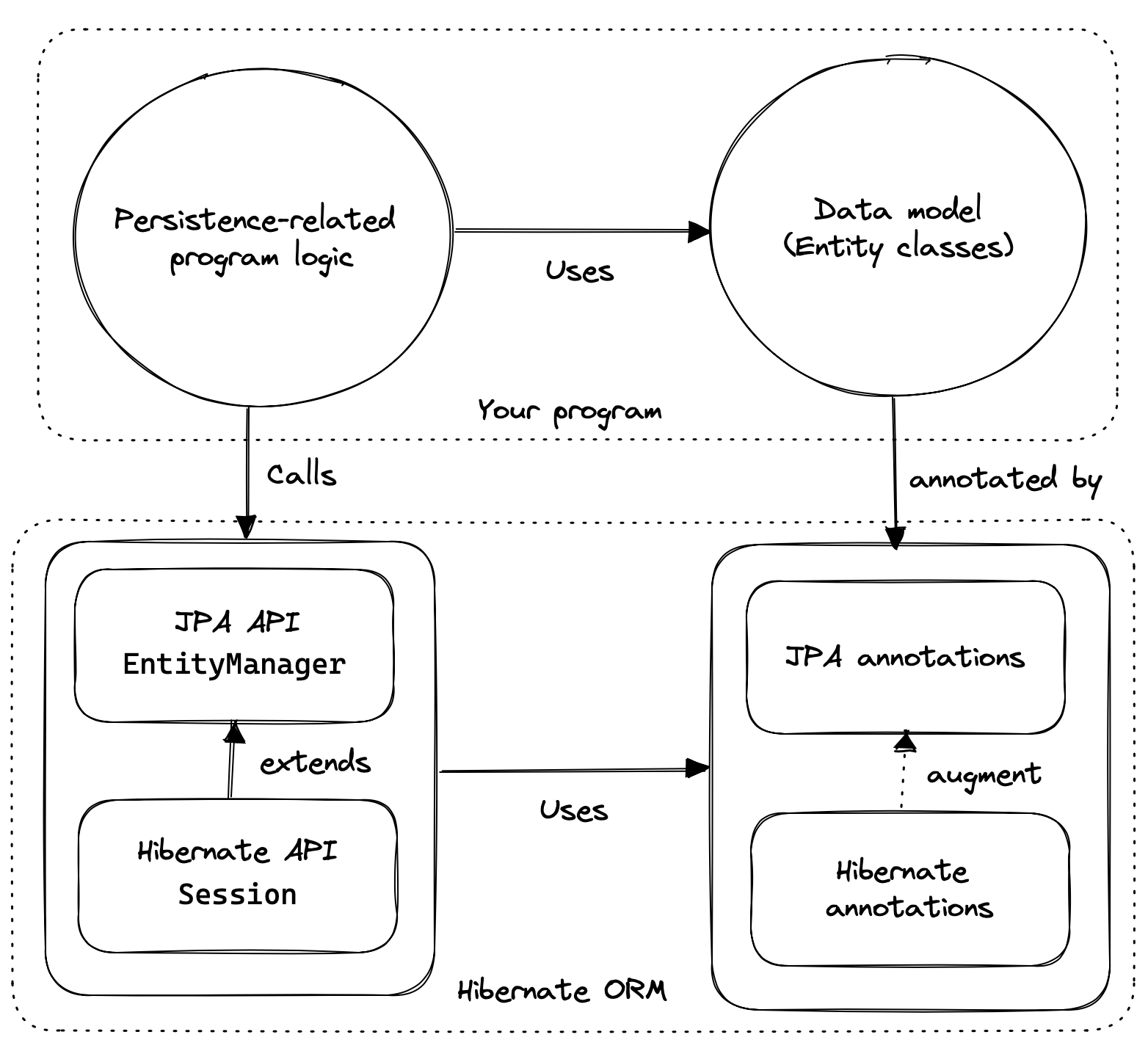

我们可以从三个基本元素的角度来思考 Hibernate API:

- JPA 定义的 API 的实现,最重要的是接口

EntityManagerFactory和 的实现EntityManager,以及 JPA 定义的 O/R 映射注释的实现, - 一个*本机 API,*公开全套可用功能,以接口为中心

SessionFactory,扩展了EntityManagerFactory、 、Session、 扩展了EntityManager、 和 - 一组映射注释,增强了 JPA 定义的 O/R 映射注释,并且可以与 JPA 定义的接口或本机 API 一起使用。

Hibernate 还为框架和库提供了一系列 SPI,用于扩展或与 Hibernate 集成,但我们对这里的任何东西都不感兴趣。

作为应用程序开发人员,您必须决定是否:

- 用

Session和SessionFactory或来编写你的程序 - 通过在合理的情况下,根据

EntityManager和编写代码EntityManagerFactory,仅在必要时回退到本机 API,最大限度地提高对 JPA 其他实现的可移植性。

无论选择哪条路径,大多数时候您都将使用 JPA 定义的映射注释,而 Hibernate 定义的注释则用于解决更高级的映射问题。

| 您可能想知道是否可以仅使用JPA 定义的 API 来开发应用程序,事实上,原则上这是可能的。JPA 是一个很好的基线,它真正解决了对象/关系映射问题的基础知识。但如果没有本机 API 和扩展映射注释,您将无法享受 Hibernate 的大部分功能。 | |

|---|---|

由于 Hibernate 在 JPA 之前就已经存在,并且 JPA 是在 Hibernate 的基础上建模的,因此不幸的是,标准 API 和本机 API 之间的命名存在一些竞争和重复。例如:

| 休眠 | 日本PA |

|---|---|

org.hibernate.annotations.CascadeType | javax.persistence.CascadeType |

org.hibernate.FlushMode | javax.persistence.FlushModeType |

org.hibernate.annotations.FetchMode | javax.persistence.FetchType |

org.hibernate.query.Query | javax.persistence.Query |

org.hibernate.Cache | javax.persistence.Cache |

@org.hibernate.annotations.NamedQuery | @javax.persistence.NamedQuery |

@org.hibernate.annotations.Cache | @javax.persistence.Cacheable |

通常,Hibernate 原生 API 会提供 JPA 中缺少的一些额外功能,因此这并不完全是一个缺陷。但这是需要注意的事情。

1.2. 使用 Hibernate 编写 Java 代码

如果您对 Hibernate 和 JPA 完全陌生,您可能已经想知道与持久性相关的代码是如何构造的。

通常,我们与持久性相关的代码分为两层:

- Java 数据模型的表示形式,采用一组带注释的实体类的形式,以及

- 大量与 Hibernate API 交互的函数,以执行与各种事务相关的持久性操作。

第一部分,即数据或“域”模型,通常更容易编写,但出色且非常干净的工作将强烈影响第二部分的成功。

大多数人将域模型实现为一组我们过去所说的“普通旧 Java 对象”,即简单的 Java 类,不直接依赖于技术基础设施,也不依赖于处理请求处理、事务管理的应用程序逻辑,通信,或与数据库的交互。

花点时间编写此代码,并尝试生成一个尽可能合理地接近关系数据模型的 Java 模型。当真正不需要时,避免使用奇异或高级的映射功能。如果有丝毫疑问,请优先使用@ManyToOnewith来映射外键关系,而不是更复杂的关联映射。@OneToMany(mappedBy=…) | |

|---|---|

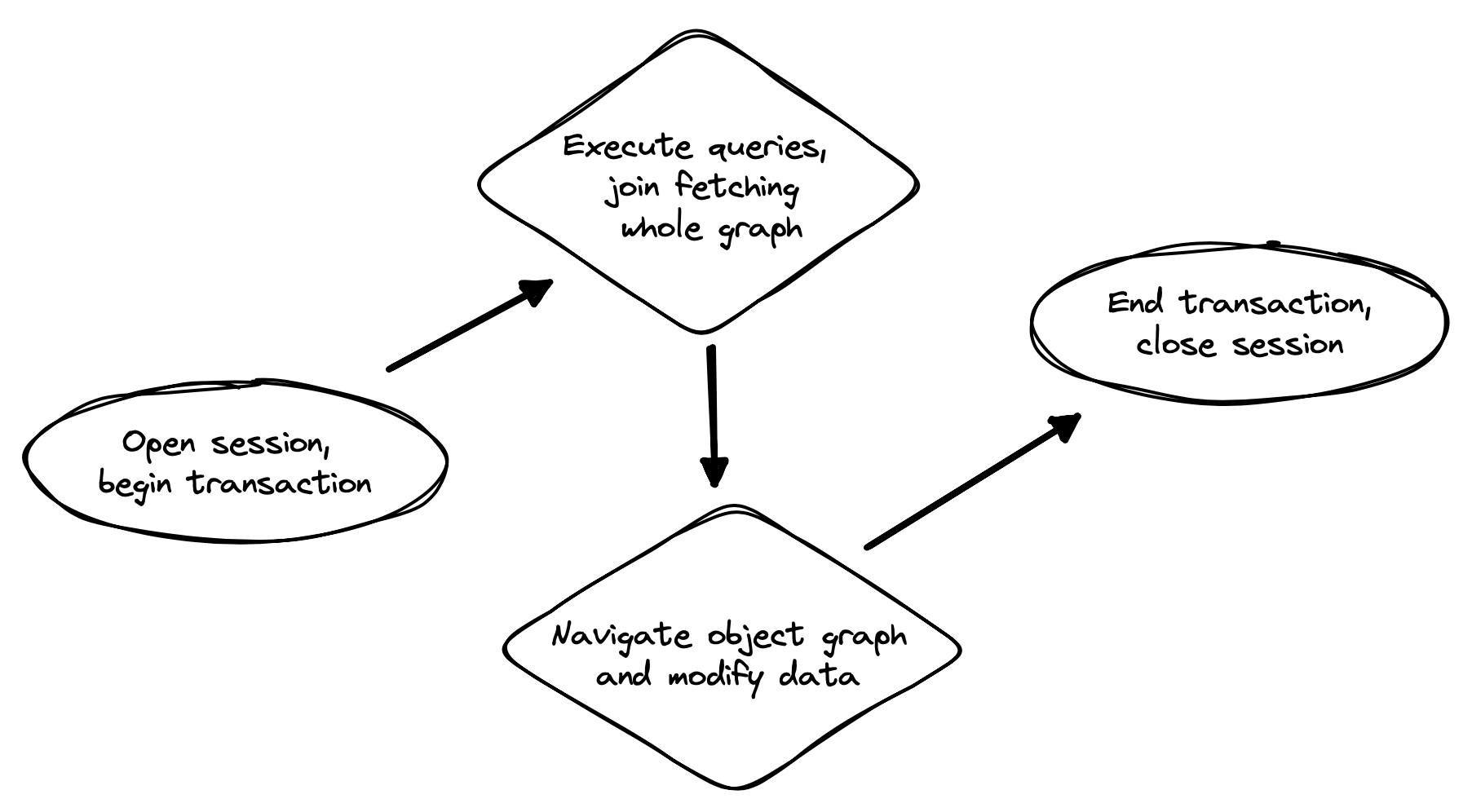

代码的第二部分要正确执行要困难得多。该代码必须:

- 管理事务和会话,

- 通过 Hibernate 会话与数据库交互,

- 获取并准备 UI 所需的数据,以及

- 处理故障。

| 事务和会话管理以及从某些类型的故障中恢复的责任最好在某种框架代码中处理。 | |

|---|---|

我们很快就会回到这个棘手的问题,即应该如何组织这种持久性逻辑,以及它应该如何适应系统的其余部分。

1.3. 你好,Hibernate

在我们深入了解之前,我们将快速介绍一个基本的示例程序,如果您尚未将 Hibernate 集成到您的项目中,它将帮助您入门。

我们从一个简单的 gradle 构建文件开始:

build.gradle

plugins {

id 'java'

}

group = 'org.example'

version = '1.0-SNAPSHOT'

repositories {

mavenCentral()

}

dependencies {

// the GOAT ORM

implementation 'org.hibernate.orm:hibernate-core:6.3.0.Final'

// Hibernate Validator

implementation 'org.hibernate.validator:hibernate-validator:8.0.0.Final'

implementation 'org.glassfish:jakarta.el:4.0.2'

// Agroal connection pool

implementation 'org.hibernate.orm:hibernate-agroal:6.3.0.Final'

implementation 'io.agroal:agroal-pool:2.1'

// logging via Log4j

implementation 'org.apache.logging.log4j:log4j-core:2.20.0'

// JPA Metamodel Generator

annotationProcessor 'org.hibernate.orm:hibernate-jpamodelgen:6.3.0.Final'

// Compile-time checking for HQL

//implementation 'org.hibernate:query-validator:2.0-SNAPSHOT'

//annotationProcessor 'org.hibernate:query-validator:2.0-SNAPSHOT'

// H2 database

runtimeOnly 'com.h2database:h2:2.1.214'

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

只有第一个依赖项是运行 Hibernate所必需的。

接下来,我们将为 log4j 添加日志配置文件:log4j2.properties

properties

rootLogger.level = info

rootLogger.appenderRefs = console

rootLogger.appenderRef.console.ref = console

logger.hibernate.name = org.hibernate.SQL

logger.hibernate.level = info

appender.console.name = console

appender.console.type = Console

appender.console.layout.type = PatternLayout

appender.console.layout.pattern = %highlight{[%p]} %m%n1

2

3

4

5

6

7

8

9

10

11

2

3

4

5

6

7

8

9

10

11

现在我们需要一些 Java 代码。我们从实体类开始:Book.java

java

package org.hibernate.example;

import jakarta.persistence.Entity;

import jakarta.persistence.Id;

import jakarta.validation.constraints.NotNull;

@Entity

class Book {

@Id

String isbn;

@NotNull

String title;

Book() {}

Book(String isbn, String title) {

this.isbn = isbn;

this.title = title;

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

最后,让我们看看配置和实例化 Hibernate 并要求其持久化和查询实体的代码。如果现在这毫无意义,请不要担心。本简介的任务就是让这一切变得清晰。Main.java

java

package org.hibernate.example;

import org.hibernate.cfg.Configuration;

import static java.lang.Boolean.TRUE;

import static java.lang.System.out;

import static org.hibernate.cfg.AvailableSettings.*;

public class Main {

public static void main(String[] args) {

var sessionFactory = new Configuration()

.addAnnotatedClass(Book.class)

// use H2 in-memory database

.setProperty(URL, "jdbc:h2:mem:db1")

.setProperty(USER, "sa")

.setProperty(PASS, "")

// use Agroal connection pool

.setProperty("hibernate.agroal.maxSize", "20")

// display SQL in console

.setProperty(SHOW_SQL, TRUE.toString())

.setProperty(FORMAT_SQL, TRUE.toString())

.setProperty(HIGHLIGHT_SQL, TRUE.toString())

.buildSessionFactory();

// export the inferred database schema

sessionFactory.getSchemaManager().exportMappedObjects(true);

// persist an entity

sessionFactory.inTransaction(session -> {

session.persist(new Book("9781932394153", "Hibernate in Action"));

});

// query data using HQL

sessionFactory.inSession(session -> {

out.println(session.createSelectionQuery("select isbn||': '||title from Book").getSingleResult());

});

// query data using criteria API

sessionFactory.inSession(session -> {

var builder = sessionFactory.getCriteriaBuilder();

var query = builder.createQuery(String.class);

var book = query.from(Book.class);

query.select(builder.concat(builder.concat(book.get(Book_.isbn), builder.literal(": ")),

book.get(Book_.title)));

out.println(session.createSelectionQuery(query).getSingleResult());

});

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

这里我们使用了 Hibernate 的原生 API。我们可以使用 JPA 标准 API 来实现同样的目的。

1.4. 你好,JPA

如果我们限制自己使用 JPA 标准 API,则需要使用 XML 来配置 Hibernate。META-INF/persistence.xml

xml

<persistence xmlns="https://jakarta.ee/xml/ns/persistence"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="https://jakarta.ee/xml/ns/persistence https://jakarta.ee/xml/ns/persistence/persistence_3_0.xsd"

version="3.0">

<persistence-unit name="example">

<class>org.hibernate.example.Book</class>

<properties>

<!-- H2 in-memory database -->

<property name="jakarta.persistence.jdbc.url"

value="jdbc:h2:mem:db1"/>

<!-- Credentials -->

<property name="jakarta.persistence.jdbc.user"

value="sa"/>

<property name="jakarta.persistence.jdbc.password"

value=""/>

<!-- Agroal connection pool -->

<property name="hibernate.agroal.maxSize"

value="20"/>

<!-- display SQL in console -->

<property name="hibernate.show_sql" value="true"/>

<property name="hibernate.format_sql" value="true"/>

<property name="hibernate.highlight_sql" value="true"/>

</properties>

</persistence-unit>

</persistence>1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

请注意,我们的build.gradle和log4j2.properties文件未更改。

我们的实体类也与之前没有变化。

不幸的是,JPA 没有提供inSession()方法,因此我们必须自己实现会话和事务管理。我们可以将该逻辑放入我们自己的inSession()函数中,这样我们就不必为每笔交易重复它。同样,您现在不需要理解任何代码。

Main.java(JPA版)

package org.hibernate.example;

import jakarta.persistence.EntityManager;

import jakarta.persistence.EntityManagerFactory;

import java.util.Map;

import java.util.function.Consumer;

import static jakarta.persistence.Persistence.createEntityManagerFactory;

import static java.lang.System.out;

import static org.hibernate.cfg.AvailableSettings.JAKARTA_HBM2DDL_DATABASE_ACTION;

import static org.hibernate.tool.schema.Action.CREATE;

public class Main {

public static void main(String[] args) {

var factory = createEntityManagerFactory("example",

// export the inferred database schema

Map.of(JAKARTA_HBM2DDL_DATABASE_ACTION, CREATE));

// persist an entity

inSession(factory, entityManager -> {

entityManager.persist(new Book("9781932394153", "Hibernate in Action"));

});

// query data using HQL

inSession(factory, entityManager -> {

out.println(entityManager.createQuery("select isbn||': '||title from Book").getSingleResult());

});

// query data using criteria API

inSession(factory, entityManager -> {

var builder = factory.getCriteriaBuilder();

var query = builder.createQuery(String.class);

var book = query.from(Book.class);

query.select(builder.concat(builder.concat(book.get(Book_.isbn), builder.literal(": ")),

book.get(Book_.title)));

out.println(entityManager.createQuery(query).getSingleResult());

});

}

// do some work in a session, performing correct transaction management

static void inSession(EntityManagerFactory factory, Consumer<EntityManager> work) {

var entityManager = factory.createEntityManager();

var transaction = entityManager.getTransaction();

try {

transaction.begin();

work.accept(entityManager);

transaction.commit();

}

catch (Exception e) {

if (transaction.isActive()) transaction.rollback();

throw e;

}

finally {

entityManager.close();

}

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

36

37

38

39

40

41

42

43

44

45

46

47

48

49

50

51

52

53

54

55

56

57

58

在实践中,我们从不直接从方法访问数据库main()。那么现在我们来谈谈如何在实际系统中组织持久化逻辑。本章的其余部分不是强制性的。如果您渴望了解有关 Hibernate 本身的更多详细信息,非常欢迎您直接跳到下一章,稍后再回来。

1.5. 组织持久性逻辑

在真实的程序中,像上面所示的代码这样的持久性逻辑通常与其他类型的代码交织在一起,包括逻辑:

- 实施业务领域的规则,或

- 用于与用户交互。

因此,许多开发人员很快(在我们看来甚至太快了)寻求将持久性逻辑隔离到某种单独的架构层中的方法。我们现在要求你抑制这种冲动。

使用Hibernate最简单的方法是直接调用Sessionor EntityManager。如果您是 Hibernate 新手,那么包装 JPA 的框架只会让您的生活变得更加困难。 | |

|---|---|

我们更喜欢采用自下而上的方法来组织代码。我们喜欢开始考虑方法和功能,而不是架构层和容器管理的对象。为了说明我们提倡的代码组织方法,让我们考虑一个使用 HQL 或 SQL 查询数据库的服务。

我们可能会从这样的东西开始,即 UI 和持久性逻辑的混合:

@Path("/") @Produces("application/json")

public class BookResource {

@GET @Path("book/{isbn}")

public Book getBook(String isbn) {

var book = sessionFactory.fromTransaction(session -> session.find(Book.class, isbn));

return book == null ? Response.status(404).build() : book;

}

}1

2

3

4

5

6

7

8

2

3

4

5

6

7

8

事实上,我们也可能会以类似的方式结束——很难识别出上面的代码有什么具体错误,而且对于这样一个简单的情况,似乎很难证明通过引入额外的对象使这段代码变得更加复杂是合理的。

我们希望引起您注意的这段代码的一个非常好的方面是,会话和事务管理是由通用“框架”代码处理的,正如我们上面已经推荐的那样。在本例中,我们使用的fromTransaction()方法恰好内置于 Hibernate 中。但您可能更喜欢使用其他东西,例如:

- 在 Jakarta EE 或 Quarkus 等容器环境中,容器管理的事务和容器管理的持久性上下文,或者

- 你自己写的东西。

重要的是,像createEntityManager()和那样的调用getTransaction().begin()不属于常规程序逻辑,因为正确处理错误既棘手又乏味。

现在让我们考虑一个稍微复杂的情况。

@Path("/") @Produces("application/json")

public class BookResource {

private static final RESULTS_PER_PAGE = 20;

@GET @Path("books/{titlePattern}/{page:\\d+}")

public List<Book> findBooks(String titlePattern, int page) {

var books = sessionFactory.fromTransaction(session -> {

return session.createSelectionQuery("from Book where title like ?1 order by title", Book.class)

.setParameter(1, titlePattern)

.setPage(Page.page(RESULTS_PER_PAGE, page))

.getResultList();

});

return books.isEmpty() ? Response.status(404).build() : books;

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

这很好,如果您希望将代码保留为上面显示的样子,我们不会抱怨。但有一件事我们也许可以改进。我们喜欢具有单一职责的超短方法,并且看起来有机会在这里介绍一种方法。让我们用我们最喜欢的东西来编写代码,即提取方法重构。我们获得:

static List<Book> findBooksByTitleWithPagination(Session session,

String titlePattern, Page page) {

return session.createSelectionQuery("from Book where title like ?1 order by title", Book.class)

.setParameter(1, titlePattern)

.setPage(page)

.getResultList();

}1

2

3

4

5

6

7

2

3

4

5

6

7

这是一个查询方法的示例,该方法接受 HQL 或 SQL 查询参数的参数,并执行查询,将其结果返回给调用者。这就是它的全部作用;它不编排额外的程序逻辑,也不执行事务或会话管理。

最好使用注释指定查询字符串,以便 Hibernate 可以在启动时(即创建时,而不是首次执行查询时@NamedQuery验证查询) 。SessionFactory事实上,由于我们在Gradle 构建中包含了元模型生成器,因此甚至可以在编译时验证查询。

我们需要一个地方来放置注释,所以让我们将查询方法移动到一个新类:

@CheckHQL // validate named queries at compile time

@NamedQuery(name="findBooksByTitle",

query="from Book where title like :title order by title")

class Queries {

static List<Book> findBooksByTitleWithPagination(Session session,

String titlePattern, Page page) {

return session.createNamedQuery("findBooksByTitle", Book.class)

.setParameter("title", titlePattern)

.setPage(page)

.getResultList();

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

2

3

4

5

6

7

8

9

10

11

12

13

EntityManager请注意,我们的查询方法不会尝试向客户端隐藏。事实上,客户端代码负责向查询方法提供EntityManageror 。Session这是我们整个方法的一个非常独特的特征。

客户端代码可以:

- 通过调用

EntityManageror获得or ,如我们上面所见,或者,Session``inTransaction()``fromTransaction() - 在具有容器管理事务的环境中,它可能通过依赖项注入来获取它。

无论哪种情况,编排工作单元的代码通常只是直接调用Sessionor EntityManager,如有必要,将其传递给辅助方法(例如我们的查询方法)。

@GET

@Path("books/{titlePattern}")

public List<Book> findBooks(String titlePattern) {

var books = sessionFactory.fromTransaction(session ->

Queries.findBooksByTitleWithPagination(session, titlePattern,

Page.page(RESULTS_PER_PAGE, page));

return books.isEmpty() ? Response.status(404).build() : books;

}1

2

3

4

5

6

7

8

2

3

4

5

6

7

8

您可能会认为我们的查询方法看起来有点样板。也许确实如此,但我们更担心它不是很类型安全。事实上,多年来,缺乏对 HQL 查询和将参数绑定到查询参数的代码的编译时检查是我们对 Hibernate 感到不适的第一个原因。

幸运的是,现在这两个问题都有一个解决方案:作为 Hibernate 6.3 的孵化功能,我们现在提供让元模型生成器为您填充此类查询方法的实现的可能性。此功能是本简介的一整章的主题,因此现在我们只给您留下一个简单的示例。

假设我们简化Queries为以下内容:

interface Queries {

@HQL("where title like :title order by title")

List<Book> findBooksByTitleWithPagination(String title, Page page);

}1

2

3

4

2

3

4

@HQL然后,元模型生成器会自动生成名为 的类中注释的方法的实现Queries_。我们可以像调用手写版本一样调用它:

@GET

@Path("books/{titlePattern}")

public List<Book> findBooks(String titlePattern) {

var books = sessionFactory.fromTransaction(session ->

Queries_.findBooksByTitleWithPagination(session, titlePattern,

Page.page(RESULTS_PER_PAGE, page));

return books.isEmpty() ? Response.status(404).build() : books;

}1

2

3

4

5

6

7

8

2

3

4

5

6

7

8

在这种情况下,消除的代码量非常小。真正的价值在于提高类型安全性。现在,我们发现编译时将参数分配给查询参数时出现的错误。

| 至此,我们确信您对这个想法充满了怀疑。确实如此。我们很乐意在这里回答您的反对意见,但这将使我们偏离正轨。所以我们要求你暂时把这些想法收起来。我们保证,当我们稍后正确解决这个主题时,它会变得有意义。并且,之后,如果您仍然不喜欢这种方法,请理解它是完全可选的。没有人会到你家来强迫你接受它。 | |

|---|---|

现在我们已经大致了解了持久性逻辑可能是什么样子,很自然地会问我们应该如何测试我们的代码。

1.6. 测试持久性逻辑

当我们为持久性逻辑编写测试时,我们将需要:

- 一个数据库,与

- 由我们的持久实体映射的模式实例,以及

- 一组测试数据,在每次测试开始时处于明确定义的状态。

似乎很明显,我们应该针对将在生产中使用的相同数据库系统进行测试,并且实际上,我们当然应该至少对此配置进行*一些测试。*但另一方面,执行 I/O 的测试比不执行 I/O 的测试慢得多,并且大多数数据库无法设置为进程内运行。

因此,由于使用 Hibernate 6 编写的大多数持久性逻辑在数据库之间具有极强的可移植性,因此针对内存中 Java 数据库进行测试通常很有意义。(我们推荐H2 。)

| 如果我们的持久性代码使用本机 SQL,或者如果它使用悲观锁等并发管理功能,那么我们确实需要小心。 | |

|---|---|

无论我们是针对真实数据库进行测试,还是针对内存中的 Java 数据库进行测试,我们都需要在测试套件开始时导出模式。我们通常在创建 HibernateSessionFactory或 JPA时执行此操作EntityManager,因此传统上我们为此使用配置属性。

JPA 标准属性是jakarta.persistence.schema-generation.database.action. 例如,如果我们使用ConfigurationHibernate 配置,我们可以这样写:

configuration.setProperty(AvailableSettings.JAKARTA_HBM2DDL_DATABASE_ACTION,

Action.SPEC_ACTION_DROP_AND_CREATE);1

2

2

或者,在 Hibernate 6 中,我们可以使用新的SchemaManagerAPI 来导出模式,就像我们上面所做的那样。

sessionFactory.getSchemaManager().exportMappedObjects(true);1

由于在许多数据库上执行 DDL 语句非常慢,因此我们不想在每次测试之前都执行此操作。相反,为了确保每个测试都以处于明确定义状态的测试数据开始,我们需要在每个测试之前做两件事:

- 清理之前测试留下的任何混乱,然后

- 重新初始化测试数据。

我们可以使用SchemaManager.

sessionFactory.getSchemaManager().truncateMappedObjects();1

截断表后,我们可能需要初始化测试数据。我们可以在SQL脚本中指定测试数据,例如:

/导入.sql

insert into Books (isbn, title) values ('9781932394153', 'Hibernate in Action')

insert into Books (isbn, title) values ('9781932394887', 'Java Persistence with Hibernate')

insert into Books (isbn, title) values ('9781617290459', 'Java Persistence with Hibernate, Second Edition')1

2

3

2

3

如果我们将此文件命名为import.sql,并将其放置在根类路径中,这就是我们需要做的。

否则,我们需要在配置属性 jakarta.persistence.sql-load-script-source中指定该文件。如果我们使用ConfigurationHibernate 配置,我们可以这样写:

configuration.setProperty(AvailableSettings.JAKARTA_HBM2DDL_LOAD_SCRIPT_SOURCE,

"/org/example/test-data.sql");1

2

2

SQL脚本每次exportMappedObjects()或被truncateMappedObjects()调用时都会被执行。

测试可能会留下另一种混乱:二级缓存中的缓存数据。我们建议对大多数类型的测试禁用Hibernate 的二级缓存。或者,如果二级缓存没有禁用,那么在每次测试之前我们应该调用:sessionFactory.getCache().evictAllRegions(); | |

|---|---|

现在,假设您已遵循我们的建议,并编写了实体和查询方法来最大程度地减少对“基础设施”的依赖,即对 JPA 和 Hibernate 以外的库、框架、容器管理对象,甚至是对某些库的依赖。您自己的系统很难从头开始实例化。那么测试持久性逻辑现在就很简单了!

您需要:

- 引导 Hibernate 并创建一个

SessionFactoryorEntityManagerFactory和测试套件的开头(我们已经了解了如何做到这一点),以及 - 在每个方法中创建一个新的

Session或,例如使用 。EntityManager``@Test``inTransaction()

实际上,某些测试可能需要多次会话。但请注意不要泄漏不同测试之间的会话。

我们需要的另一个重要测试是根据实际数据库模式验证我们的O/R 映射注释。这又是模式管理工具的工作,或者:configuration.setProperty(AvailableSettings.JAKARTA_HBM2DDL_DATABASE_ACTION, Action.ACTION_VALIDATE);或者:sessionFactory.getSchemaManager().validateMappedObjects();即使在生产中,当系统启动时,许多人也喜欢运行此“测试”。 | |

|---|---|

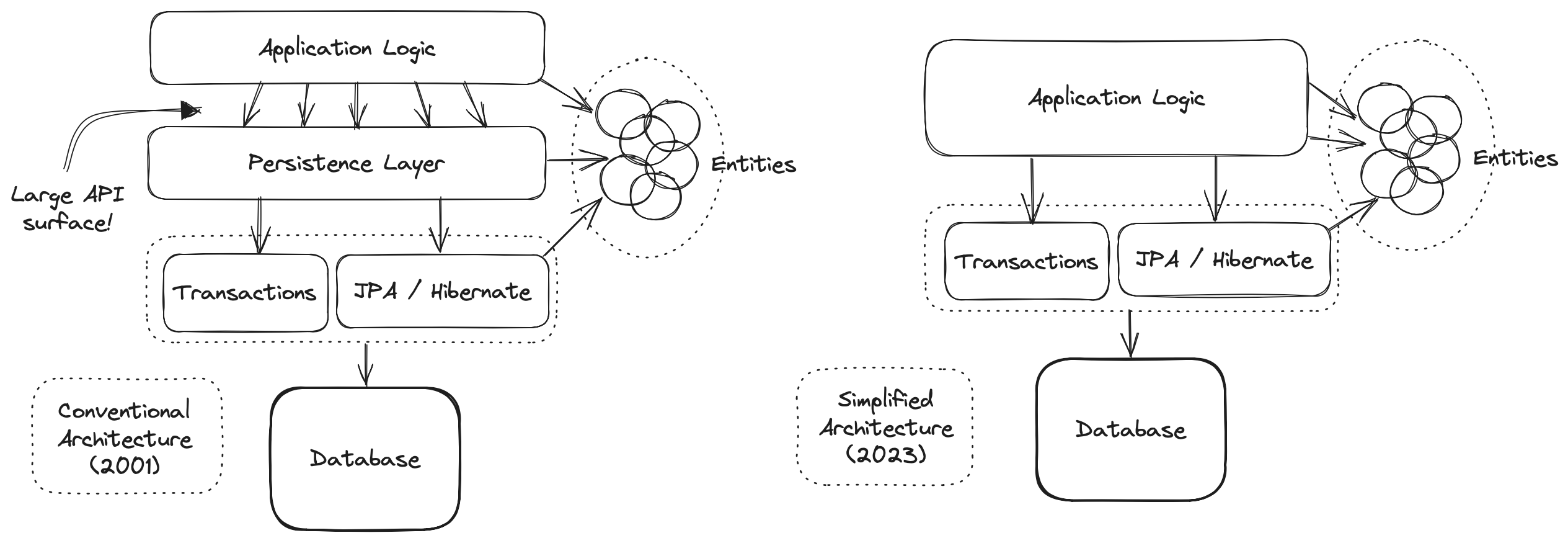

1.7. 架构和持久层

现在让我们考虑一种不同的代码组织方法,我们对此持怀疑态度。

| 在本节中,我们将向您提供我们的意见。如果您只对事实感兴趣,或者如果您不想阅读可能会破坏您当前持有的观点的内容,请随时直接跳到下一章。 | |

|---|---|

Hibernate 是一个与体系结构无关的库,而不是一个框架,因此可以与各种 Java 框架和容器轻松集成。与我们在生态系统中的地位一致,我们历来避免提供太多关于架构的建议。这是我们现在可能会后悔的做法,因为由此产生的真空已经被提倡架构、设计模式和额外框架的人们的建议所填充,我们怀疑这些建议使 Hibernate 使用起来不太愉快。 。

特别是,包装 JPA 的框架似乎增加了臃肿性,同时又减少了 Hibernate 努力提供的一些对数据访问的细粒度控制。这些框架没有公开 Hibernate 的完整功能集,因此程序被迫使用功能较弱的抽象。

我们之所以犹豫是否要挑战这种古板、教条式的传统智慧,只是因为担心不可避免地伴随着这种教条式的引诱,我们会被直立的烦恼所刺痛:

与数据库交互的代码属于单独的持久层。

我们缺乏勇气——也许甚至缺乏信念——来明确告诉你不要遵循这个建议。但我们确实要求您考虑任何架构层的样板成本,以及在您的系统环境中这种成本所带来的好处是否真的值得。

为了给这个讨论添加一些背景纹理,并且冒着我们的引言在如此早期阶段退化为咆哮的风险,我们将要求您在幽默地谈论更多关于古代历史的同时。

DAO 和存储库的史诗故事

回到 Java EE 4 的黑暗时代,在 Hibernate 标准化之前,以及随后 JPA 在 Java 企业开发中取得优势之前,手工编写由 Hibernate 处理的混乱的 JDBC 交互是很常见的。在那个可怕的时代,出现了一种我们称之为数据访问对象(DAO)的模式。DAO 为您提供了一个放置所有讨厌的 JDBC 代码的地方,从而使重要的程序逻辑更加清晰。

当 Hibernate 在 2001 年突然出现时,开发人员喜欢上了它。但 Hibernate 没有实现任何规范,许多人希望减少或至少本地化其项目逻辑对 Hibernate 的依赖。一个明显的解决方案是保留 DAO,但用对 Hibernate 的调用替换其中的 JDBC 代码Session。

我们对接下来发生的事情部分地责怪自己。

早在 2002 年和 2003 年,这看起来确实是一件相当合理的事情。事实上,我们通过推荐(或者至少不阻止)在Hibernate in Action中使用 DAO,为这种方法的流行做出了贡献。我们特此为这一错误以及花了太长时间才认识到这一错误表示歉意。

最终,一些人开始相信,他们的 DAO 保护了他们的程序,使其免于过分依赖 ORM,从而允许他们“换出”Hibernate,并用 JDBC 或其他东西替代它。事实上,这从来都不是真的——JDBC 的编程模型(与数据库的每次交互都是显式且同步的)与 Hibernate 中的有状态会话的编程模型(其中更新是隐式的)和 SQL 语句之间存在着很大的差异。都是异步执行的。

但随后,Java 持久性的整个格局在 2006 年 4 月发生了变化,当时 JPA 1.0 的最终草案获得了批准。Java 现在有了执行 ORM 的标准方法,以及标准 API 的多个高质量实现。这是 DAO 的终结,对吗?

嗯,不。事实并非如此。DAO 被重新命名为“存储库”,并继续作为 JPA 的前端享受僵尸来世。但它们真的发挥了作用,还是只是不必要的额外复杂性和臃肿?额外的间接层会使堆栈跟踪更难读取并且代码更难调试?

我们深思熟虑的观点是,它们大多只是臃肿。JPAEntityManager是一个“存储库”,它是一个标准存储库,具有明确定义的规范,由整天思考持久性的人们编写。如果这些存储库框架提供了任何实际有用的东西——而且不是明显的脚射——除了所提供的东西之外,我们几十年前EntityManager就已经将它添加到了。EntityManager

最终,我们不确定您是否需要一个单独的持久层。至少考虑一下EntityManager直接从业务逻辑调用的可能性。

我们已经可以听到你对我们的异端邪说发出嘶嘶声。但在关上笔记本电脑的盖子并去拿大蒜和干草叉之前,请花几个小时来权衡我们的建议。

好的,所以,看,如果这让您感觉更好,一种查看方法EntityManager是将其视为适用于系统中每个实体的单个通用“存储库”。从这个角度来看,JPA就是你的持久层。并且没有什么充分的理由将这个抽象包装在第二个不太通用的抽象中。

即使在适合使用不同持久层的情况下,DAO 风格的存储库也不是分解方程的最正确方法:

- 大多数重要的查询都会涉及多个实体,因此这样的查询属于哪个存储库通常非常模糊,

- 大多数查询都非常特定于程序逻辑的特定片段,并且不会在系统中的不同位置重用,并且

- 存储库的各种操作很少交互或共享共同的内部实现细节。

事实上,存储库本质上表现出非常低的内聚性。如果每个存储库都有多个实现,那么存储库对象层可能有意义,但实际上几乎没有人这样做。这是因为他们与客户的耦合度非常高,并且具有非常大的 API 接口。相反,只有具有非常狭窄的API 的层才可以轻松替换。

| 有些人确实使用模拟存储库进行测试,但我们真的很难看到其中的任何价值。如果我们不想针对真实数据库运行测试,通常很容易通过针对内存 Java 数据库(如 H2)运行测试来“模拟”数据库本身。这在 Hibernate 6 中比在旧版本的 Hibernate 中效果更好,因为 HQL 现在在平台之间更加可移植。 | |

|---|---|

唷,我们继续吧。

1.8. 概述

现在是时候开始真正理解我们之前看到的代码了。

本简介将指导您完成开发使用 Hibernate 进行持久化的程序所涉及的基本任务:

SessionFactory配置和引导 Hibernate,并获取或的实例EntityManagerFactory,- 编写域模型,即一组实体类,它们代表程序中的持久类型,并映射到数据库的表,

- 当模型映射到预先存在的关系模式时自定义这些映射,

- 使用

Session或EntityManager执行查询数据库并返回实体实例的操作,或更新数据库中保存的数据的操作, - 使用 Hibernate Metamodel Generator 来提高编译时类型安全性,

- 使用 Hibernate 查询语言 (HQL) 或本机 SQL 编写复杂查询,最后

- 调整数据访问逻辑的性能。

当然,我们将从这个列表的顶部开始,从最不有趣的主题:配置。

2. 配置和引导

我们很乐意缩短这一部分。不幸的是,有几种不同的方法来配置和引导 Hibernate,我们将不得不详细描述其中至少两种。

获取Hibernate实例的四种基本方式如下表所示:

使用标准的JPA定义的XML,以及操作Persistence.createEntityManagerFactory() | 通常在 JPA 实现之间的可移植性很重要时选择。 |

|---|---|

使用Configuration类来构造一个SessionFactory | 当 JPA 实现之间的可移植性并不重要时,此选项速度更快,增加了一些灵活性并节省了类型转换。 |

使用中定义的更复杂的 APIorg.hibernate.boot | 此选项主要由框架集成商使用,不属于本文档的讨论范围。 |

通过让容器负责引导过程并注入SessionFactory或EntityManagerFactory | 用于 WildFly 或 Quarkus 等容器环境。 |

这里我们将重点关注前两个选项。

在容器中休眠

实际上,最后一个选项非常流行,因为每个主要的 Java 应用程序服务器和微服务框架都内置了对 Hibernate 的支持。EntityManager此类容器环境通常还具有自动管理或的生命周期Session及其与容器管理事务的关联的功能。

要了解如何在此类容器环境中配置 Hibernate,您需要参考所选容器的文档。对于 Quarkus,这里是相关文档。

如果您在容器环境之外使用 Hibernate,则需要:

- 包含 Hibernate ORM 本身以及适当的 JDBC 驱动程序作为项目的依赖项,以及

- 通过指定配置属性,使用有关数据库的信息配置 Hibernate。

2.1. 将 Hibernate 包含在您的项目构建中

首先,将以下依赖项添加到您的项目中:

org.hibernate.orm:hibernate-core:{版本}1

{version}您正在使用的 Hibernate 版本在哪里?

您还需要为数据库添加 JDBC 驱动程序的依赖项。

| 数据库 | 驱动程序依赖 |

|---|---|

| PostgreSQL 或 CockroachDB | org.postgresql:postgresql:{version} |

| MySQL 或 TiDB | com.mysql:mysql-connector-j:{version} |

| 玛丽亚数据库 | org.mariadb.jdbc:mariadb-java-client:{version} |

| 数据库2 | com.ibm.db2:jcc:{version} |

| SQL服务器 | com.microsoft.sqlserver:mssql-jdbc:${version} |

| 甲骨文 | com.oracle.database.jdbc:ojdbc11:${version} |

| 氢2 | com.h2database:h2:{version} |

| HSQL数据库 | org.hsqldb:hsqldb:{version} |

{version}适用于您的数据库的最新版本的 JDBC 驱动程序在哪里?

2.2. 可选依赖项

您还可以选择添加以下任何附加功能:

| 可选功能 | 依赖关系 |

|---|---|

| SLF4J日志记录实现 | org.apache.logging.log4j:log4j-core 或者org.slf4j:slf4j-jdk14 |

| JDBC 连接池,例如Agroal | org.hibernate.orm:hibernate-agroal 和io.agroal:agroal-pool |

| Hibernate Metamodel Generator,特别是当您使用 JPA 条件查询 API 时 | org.hibernate.orm:hibernate-jpamodelgen |

| 查询验证器,用于 HQL 的编译时检查 | org.hibernate:query-validator |

| Hibernate Validator , Bean Validation的实现 | org.hibernate.validator:hibernate-validator 和org.glassfish:jakarta.el |

| 通过 JCache 和EHCache支持本地二级缓存 | org.hibernate.orm:hibernate-jcache 和org.ehcache:ehcache |

| 通过 JCache 和Caffeine支持本地二级缓存 | org.hibernate.orm:hibernate-jcache 和com.github.ben-manes.caffeine:jcache |

| 通过Infinispan提供分布式二级缓存支持 | org.infinispan:infinispan-hibernate-cache-v60 |

| 用于处理 JSON 数据类型的 JSON 序列化库,例如Jackson或Yasson | com.fasterxml.jackson.core:jackson-databind 或者org.eclipse:yasson |

| 休眠空间 | org.hibernate.orm:hibernate-spatial |

| Envers,用于审计历史数据 | org.hibernate.orm:hibernate-envers |

如果您想使用字段级延迟获取,您还可以将 Hibernate字节码增强器添加到 Gradle 构建中。

2.3. 使用 JPA XML 进行配置

坚持 JPA 标准方法,我们将提供一个名为 的文件persistence.xml,我们通常将其放置在持久性存档META-INF的目录中,即包含实体类的文件或目录的目录中。.jar

<persistence xmlns="http://java.sun.com/xml/ns/persistence"

xmlns:xsi="http://www.w3.org/2001/XMLSchema-instance"

xsi:schemaLocation="http://java.sun.com/xml/ns/persistence https://jakarta.ee/xml/ns/persistence/persistence_3_0.xsd"

version="2.0">

<persistence-unit name="org.hibernate.example">

<class>org.hibernate.example.Book</class>

<class>org.hibernate.example.Author</class>

<properties>

<!-- PostgreSQL -->

<property name="jakarta.persistence.jdbc.url"

value="jdbc:postgresql://localhost/example"/>

<!-- Credentials -->

<property name="jakarta.persistence.jdbc.user"

value="gavin"/>

<property name="jakarta.persistence.jdbc.password"

value="hibernate"/>

<!-- Automatic schema export -->

<property name="jakarta.persistence.schema-generation.database.action"

value="drop-and-create"/>

<!-- SQL statement logging -->

<property name="hibernate.show_sql" value="true"/>

<property name="hibernate.format_sql" value="true"/>

<property name="hibernate.highlight_sql" value="true"/>

</properties>

</persistence-unit>

</persistence>1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

30

31

32

33

34

35

该<persistence-unit>元素定义了一个命名的持久单元,即:

- 关联实体类型的集合,以及

- 一组默认配置设置,可以在运行时增强或覆盖。

每个<class>元素指定实体类的完全限定名称。

扫描实体类

在某些容器环境中,例如在任何 EE 容器中,这些<class>元素是不必要的,因为容器将扫描存档中的带注释的类,并自动识别任何带注释的类@Entity。

每个<property>元素指定一个配置属性及其值。注意:

- 命名空间中的配置属性

jakarta.persistence是 JPA 规范定义的标准属性,并且 - 命名空间中的属性

hibernate是 Hibernate 特有的。

EntityManagerFactory我们可以通过致电获取Persistence.createEntityManagerFactory():

EntityManagerFactory entityManagerFactory =

Persistence.createEntityManagerFactory("org.hibernate.example");1

2

2

如有必要,我们可以覆盖中指定的配置属性persistence.xml:

EntityManagerFactory entityManagerFactory =

Persistence.createEntityManagerFactory("org.hibernate.example",

Map.of(AvailableSettings.JAKARTA_JDBC_PASSWORD, password));1

2

3

2

3

2.4. 使用 Hibernate API 进行配置

或者,古老的类Configuration允许在 Java 代码中配置 Hibernate 实例。

SessionFactory sessionFactory =

new Configuration()

.addAnnotatedClass(Book.class)

.addAnnotatedClass(Author.class)

// PostgreSQL

.setProperty(AvailableSettings.JAKARTA_JDBC_URL, "jdbc:postgresql://localhost/example")

// Credentials

.setProperty(AvailableSettings.JAKARTA_JDBC_USER, user)

.setProperty(AvailableSettings.JAKARTA_JDBC_PASSWORD, password)

// Automatic schema export

.setProperty(AvailableSettings.JAKARTA_HBM2DDL_DATABASE_ACTION,

Action.SPEC_ACTION_DROP_AND_CREATE)

// SQL statement logging

.setProperty(AvailableSettings.SHOW_SQL, TRUE.toString())

.setProperty(AvailableSettings.FORMAT_SQL, TRUE.toString())

.setProperty(AvailableSettings.HIGHLIGHT_SQL, TRUE.toString())

// Create a new SessionFactory

.buildSessionFactory();1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

Configuration自 Hibernate 的最早版本(1.0 之前)以来,该类几乎没有发生任何变化,因此它看起来并不是特别现代。另一方面,它非常易于使用,并公开了一些persistence.xml不支持的选项。

高级配置选项

实际上,该类Configuration只是一个非常简单的外观,用于包中定义的更现代、更强大(但更复杂)的 API org.hibernate.boot。如果您有非常高级的需求,例如,如果您正在编写框架或实现容器,则此 API 非常有用。您可以在用户指南和的包级文档中找到更多信息org.hibernate.boot。

2.5. 使用 Hibernate 属性文件进行配置

如果我们使用 Hibernate ConfigurationAPI,但不想将某些配置属性直接放入 Java 代码中,则可以在名为 的文件中指定它们,hibernate.properties并将该文件放在根类路径中。

# PostgreSQL

jakarta.persistence.jdbc.url=jdbc:postgresql://localhost/example

# Credentials

jakarta.persistence.jdbc.user=hibernate

jakarta.persistence.jdbc.password=zAh7mY$2MNshzAQ5

# SQL statement logging

hibernate.show_sql=true

hibernate.format_sql=true

hibernate.highlight_sql=true1

2

3

4

5

6

7

8

9

10

2

3

4

5

6

7

8

9

10

2.6。基本配置设置

该类枚举AvailableSettings了 Hibernate 理解的所有配置属性。

当然,我们不会在本章中介绍所有有用的配置设置。相反,我们将提及您开始时需要的设置,并稍后返回一些其他重要设置,特别是当我们谈论性能调整时。

| Hibernate 有太多——太多——开关和切换。请不要疯狂地摆弄这些设置;其中大多数很少需要,并且许多的存在只是为了提供与旧版本 Hibernate 的向后兼容性。除了极少数例外,这些设置中每一项的默认行为都是经过精心选择的,作为我们推荐的行为。 | |

|---|---|

您真正开始需要的属性是这三个:

| 配置属性名称 | 目的 |

|---|---|

jakarta.persistence.jdbc.url | 数据库的 JDBC URL |

jakarta.persistence.jdbc.user和jakarta.persistence.jdbc.password | 您的数据库凭据 |

在 Hibernate 6 中,您不需要指定hibernate.dialect. Dialect将自动为您确定正确的 Hibernate SQL 。指定此属性的唯一原因是您使用的是自定义的用户编写的Dialect类。同样,在使用受支持的数据库之一时,也不需要hibernate.connection.driver_class或不需要。jakarta.persistence.jdbc.driver | |

|---|---|

池化 JDBC 连接是一项极其重要的性能优化。您可以使用此属性设置 Hibernate 内置连接池的大小:

| 配置属性名称 | 目的 |

|---|---|

hibernate.connection.pool_size | 内置连接池的大小 |

| 默认情况下,Hibernate 使用简单的内置连接池。这个池并不适合在生产中使用,稍后,当我们讨论性能时,我们将看到如何选择更健壮的实现。 | |

|---|---|

或者,在容器环境中,您至少需要以下属性之一:

| 配置属性名称 | 目的 |

|---|---|

jakarta.persistence.transactionType | (可选,默认为JTA)确定事务管理是通过 JTA 还是资源本地事务。指定RESOURCE_LOCAL是否不应使用 JTA。 |

jakarta.persistence.jtaDataSource | JTA 数据源的 JNDI 名称 |

jakarta.persistence.nonJtaDataSource | 非 JTA 数据源的 JNDI 名称 |

在这种情况下,Hibernate 从容器管理的DataSource.

2.7. 自动模式导出

您可以让 Hibernate 根据您在 Java 代码中指定的映射注释推断您的数据库模式,并通过指定以下一个或多个配置属性在初始化时导出该模式:

| 配置属性名称 | 目的 |

|---|---|

jakarta.persistence.schema-generation.database.action | 如果drop-and-create,首先删除架构,然后导出表、序列和约束If create,导出表、序列和约束,而不尝试先删除它们如果create-drop,则删除架构并在启动时重新创建它此外,在关闭时SessionFactory删除架构SessionFactory如果,则在关闭drop时删除架构SessionFactory如果validate,验证数据库架构而不更改它如果update,则仅导出架构中缺少的内容 |

jakarta.persistence.create-database-schemas | (可选)如果true,自动创建模式和目录 |

jakarta.persistence.schema-generation.create-source | (可选)如果metadata-then-script或script-then-metadata,则在导出表和序列时执行附加 SQL 脚本 |

jakarta.persistence.schema-generation.create-script-source | (可选)要执行的SQL DDL脚本的名称 |

jakarta.persistence.sql-load-script-source | (可选)要执行的SQL DML脚本的名称 |

此功能对于测试非常有用。

使用测试或“参考”数据预初始化数据库的最简单方法是将 SQL 语句列表放置insert在名为 的文件中import.sql,并使用属性 指定该文件的路径jakarta.persistence.sql-load-script-source。我们已经看到了这种方法的一个示例,它比编写 Java 代码来实例化实体实例并调用persist()每个实体实例更干净。 | |

|---|---|

正如我们之前提到的,以编程方式控制模式导出也很有用。

APISchemaManager允许对架构导出进行编程控制:sessionFactory.getSchemaManager().exportMappedObjects(true);JPA 有一个更有限且不太符合人体工程学的 API:Persistence.generateSchema("org.hibernate.example", Map.of(JAKARTA_HBM2DDL_DATABASE_ACTION, CREATE)) | |

|---|---|

2.8. 记录生成的 SQL

要在生成的 SQL 发送到数据库时查看它,您有两种选择。

一种方法是将属性设置hibernate.show_sql为true,Hibernate 会将 SQL 直接记录到控制台。您可以通过启用格式设置或突出显示来使输出更具可读性。这些设置在对生成的 SQL 语句进行故障排除时确实很有帮助。

| 配置属性名称 | 目的 |

|---|---|

hibernate.show_sql | 如果true,则将 SQL 直接记录到控制台 |

hibernate.format_sql | 如果true,以多行缩进格式记录 SQL |

hibernate.highlight_sql | If true,通过 ANSI 转义码使用语法突出显示记录 SQL |

org.hibernate.SQL或者,您可以使用您首选的 SLF4J 日志记录实现为该类别启用调试级别日志记录。

例如,如果您使用 Log4J 2(如上面可选依赖项中所示),请将这些行添加到您的log4j2.properties文件中:

# SQL execution

logger.hibernate.name = org.hibernate.SQL

logger.hibernate.level = debug

# JDBC parameter binding

logger.jdbc-bind.name=org.hibernate.orm.jdbc.bind

logger.jdbc-bind.level=trace

# JDBC result set extraction

logger.jdbc-extract.name=org.hibernate.orm.jdbc.extract

logger.jdbc-extract.level=trace1

2

3

4

5

6

7

8

9

10

2

3

4

5

6

7

8

9

10

但通过这种方法,我们错过了漂亮的突出显示。

2.9. 最大限度地减少重复的映射信息

@Table以下属性对于最大限度地减少需要在注释中显式指定的信息量非常有用@Column,我们将在下面的对象/关系映射中讨论这些信息:

| 配置属性名称 | 目的 |

|---|---|

hibernate.default_schema | 未显式声明实体的默认模式名称 |

hibernate.default_catalog | 未显式声明实体的默认目录名称 |

hibernate.physical_naming_strategy | APhysicalNamingStrategy实施数据库命名标准 |

hibernate.implicit_naming_strategy | 指定ImplicitNamingStrategy当注释中未指定名称时应如何推断关系对象的“逻辑”名称 |

编写自己的PhysicalNamingStrategyand/orImplicitNamingStrategy是一种特别好的方法,可以减少实体类上注释的混乱,并实现数据库命名约定,因此我们认为您应该为任何重要的数据模型执行此操作。我们将在命名策略中详细讨论它们。 | |

|---|---|

2.10. SQL Server 中的国家化字符数据

默认情况下, SQL Server 的char和varchar类型不容纳 Unicode 数据。但 Java 字符串可以包含任何 Unicode 字符。因此,如果您使用 SQL Server,您可能需要强制 Hibernate 使用nchar和nvarchar列类型。

| 配置属性名称 | 目的 |

|---|---|

hibernate.use_nationalized_character_data | 使用ncharandnvarchar代替charandvarchar |

另一方面,如果只有某些列存储国有化数据,请使用@Nationalized注释来指示映射这些列的实体的字段。

或者,您可以将 SQL Server 配置为使用启用 UTF-8 的排序规则_UTF8。 | |

|---|---|

3. 实体

实体是一个 Java类,它表示关系数据库表中的数据。我们说实体映射或者映射到表。不太常见的是,一个实体可能会聚合来自多个表的数据,但我们稍后会讨论这一点。

实体具有映射到表的列的属性(属性或字段)。特别是,每个实体都必须有一个标识符或id,它映射到表的主键。id 允许我们将表的一行与 Java 类的实例唯一关联,至少在给定的持久性上下文中是如此。

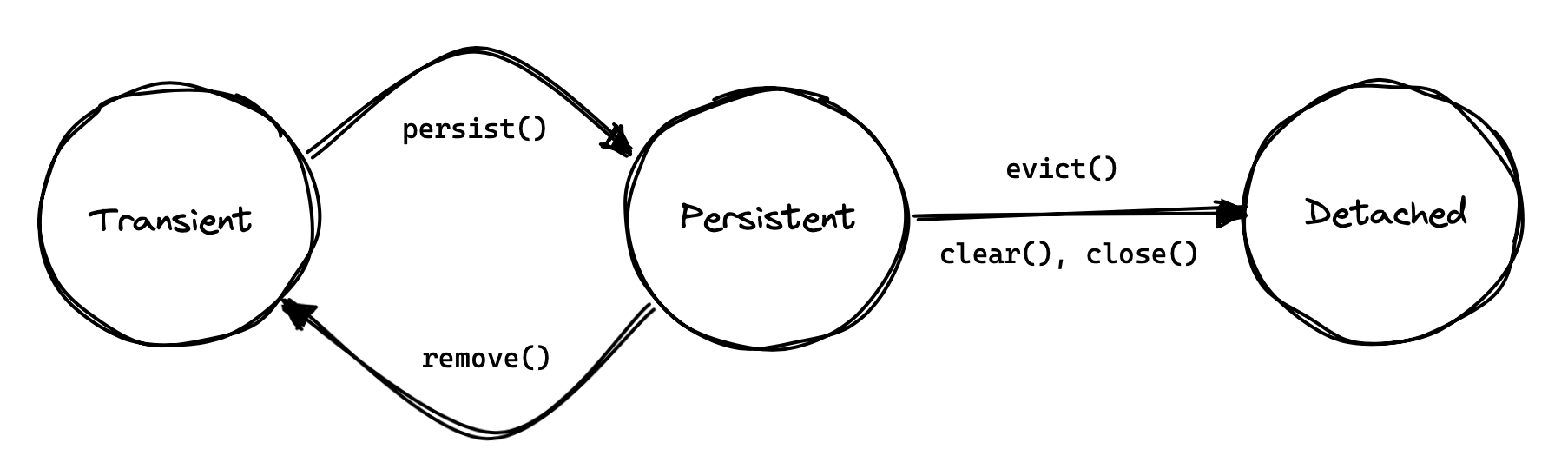

稍后我们将探讨持久性上下文的想法。现在,将其视为 id 和实体实例之间的一对一映射。

Java 类的实例不能比它所属的虚拟机存活得更久。但我们可能会认为实体实例的生命周期超越了内存中的特定实例。通过向 Hibernate 提供其 id,只要关联的行存在于数据库中,我们就可以在新的持久性上下文中重新具体化该实例。因此,操作persist()和remove()可以被认为是划分实体生命周期的开始和结束,至少在持久性方面。

因此,id 代表实体的*持久身份,该身份比内存中的特定实例更长寿。*这是实体类本身与其属性值之间的一个重要区别 - 实体具有持久标识,以及与持久性相关的明确定义的生命周期,而表示其属性值之一的 a 或 却String没有List。

一个实体通常与其他实体有关联。通常,两个实体之间的关联映射到数据库表之一中的外键。一组相互关联的实体通常称为领域模型,尽管数据模型也是一个非常好的术语。

3.1. 实体类

实体必须:

- 成为非

final阶级, - 带有

private不带参数的非构造函数。

另一方面,实体类可以是具体的abstract,也可以是具体的,并且它可以有任意数量的附加构造函数。

实体类可以是static内部类。 | |

|---|---|

每个实体类都必须带有注释@Entity。

@Entity

class Book {

Book() {}

...

}1

2

3

4

5

2

3

4

5

或者,可以通过为类提供基于 XML 的映射来将类标识为实体类型。

使用 XML 映射实体

当使用基于 XML 的映射时,该<entity>元素用于声明实体类:

<entity-mappings>

<package>org.hibernate.example</package>

<entity class="Book">

<attributes> ... </attributes>

</entity>

...

</entity-mappings>1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

由于orm.xmlJPA 规范定义的映射文件格式是在基于注释的映射的基础上紧密建模的,因此通常很容易在两个选项之间来回切换。

在本简介中,我们不会对基于 XML 的映射进行更多讨论,因为这不是我们首选的处理方式。

“动态”模型

我们喜欢将实体表示为类,因为类为我们提供了类型安全的数据模型。但 Hibernate 还能够将实体表示为 的非类型化实例java.util.Map。如果您好奇的话,用户指南中提供了信息。

对于一个重视类型安全的项目来说,这听起来一定是一个奇怪的功能。实际上,对于一种非常特殊的通用代码来说,这是一种有用的功能。例如,Hibernate Envers是一个出色的 Hibernate 实体审核/版本控制系统。Envers 使用映射来表示其数据的版本模型。

3.2. 访问类型

每个实体类都有一个默认的访问类型,可以是:

- 直接现场访问,或

- 财产准入。

Hibernate 自动根据属性级注释的位置确定访问类型。具体来说:

- 如果字段被注释

@Id,则使用字段访问,或者 - 如果 getter 方法被注释

@Id,则使用属性访问。

当 Hibernate 刚刚起步时,属性访问在 Hibernate 社区中相当流行。然而,如今,现场访问变得更加普遍。

可以使用@Access注释显式指定默认访问类型,但我们强烈建议不要这样做,因为它很丑陋而且没有必要。 | |

|---|---|

映射注释应保持一致:如果@Id注释一个字段,则其他映射注释也应应用于字段,或者,如果@Id注释 getter,则其他映射注释应应用于 getter。原则上可以@Access在属性级别使用显式注释来混合字段和属性访问。我们不建议这样做。 | |

|---|---|

类似 的实体类Book,不扩展任何其他实体类,称为根实体。每个根实体必须声明一个标识符属性。

3.3. 实体类继承

一个实体类可以是extend另一个实体类。

@Entity

class AudioBook extends Book {

AudioBook() {}

...

}1

2

3

4

5

2

3

4

5

子类实体继承其扩展的每个实体的每个持久属性。

根实体还可以扩展另一个类并从另一个类继承映射的属性。但在这种情况下,声明映射属性的类必须被注释@MappedSuperclass。

@MappedSuperclass

class Versioned {

...

}

@Entity

class Book extends Versioned {

...

}1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

根实体类必须声明一个带注释的属性@Id,或者从 a 继承一个属性@MappedSuperclass。子类实体始终继承根实体的标识符属性。它可能不声明自己的@Id属性。

3.4. 标识符属性

标识符属性通常是一个字段:

@Entity

class Book {

Book() {}

@Id

Long id;

...

}1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

但它可能是一个属性:

@Entity

class Book {

Book() {}

private Long id;

@Id

Long getId() { return id; }

void setId(Long id) { this.id = id; }

...

}1

2

3

4

5

6

7

8

9

10

11

12

2

3

4

5

6

7

8

9

10

11

12

标识符属性必须被注释@Id或@EmbeddedId。

标识符值可以是:

- 由应用程序分配,即由您的 Java 代码分配,或者

- 由 Hibernate 生成和分配。

我们将首先讨论第二个选项。

3.5. 生成的标识符

标识符通常是系统生成的,在这种情况下应该对其进行注释@GeneratedValue:

@Id @GeneratedValue

Long id;1

2

2

| 系统生成的标识符或代理键使发展或重构关系数据模型变得更加容易。如果您可以自由定义关系模式,我们建议使用代理键。另一方面,如果(更常见的是)您正在使用预先存在的数据库模式,则您可能没有选择。 | |

|---|---|

JPA 定义了以下生成 ids 的策略,通过 枚举GenerationType:

| 战略 | Java类型 | 执行 |

|---|---|---|

GenerationType.UUID | UUID或者String | 爪哇UUID |

GenerationType.IDENTITY | Long或者Integer | 标识列或自动增量列 |

GenerationType.SEQUENCE | Long或者Integer | 数据库序列 |

GenerationType.TABLE | Long或者Integer | 数据库表 |

GenerationType.AUTO | Long或者Integer | 根据数据库的标识符类型和功能选择SEQUENCE、TABLE、 或UUID |

例如,这个 UUID 是在 Java 代码中生成的:

@Id @GeneratedValue UUID id; // AUTO strategy selects UUID based on the field type1

此 id 映射到 SQL identity、auto_increment或bigserial列:

@Id @GeneratedValue(strategy=IDENTITY) Long id;1

The @SequenceGenerator and @TableGenerator annotations allow further control over SEQUENCE and TABLE generation respectively.

Consider this sequence generator:

@SequenceGenerator(name="bookSeq", sequenceName="seq_book", initialValue = 5, allocationSize=10)1

Values are generated using a database sequence defined as follows:

create sequence seq_book start with 5 increment by 101

Notice that Hibernate doesn’t have to go to the database every time a new identifier is needed. Instead, a given process obtains a block of ids, of size allocationSize, and only needs to hit the database each time the block is exhausted. Of course, the downside is that generated identifiers are not contiguous.

If you let Hibernate export your database schema, the sequence definition will have the right start with and increment values. But if you’re working with a database schema managed outside Hibernate, make sure the initialValue and allocationSize members of @SequenceGenerator match the start with and increment specified in the DDL. | |

|---|---|

Any identifier attribute may now make use of the generator named bookSeq:

@Id

@GeneratedValue(strategy=SEQUENCE, generator="bookSeq") // reference to generator defined elsewhere

Long id;1

2

3

2

3

Actually, it’s extremely common to place the @SequenceGenerator annotation on the @Id attribute that makes use of it:

@Id

@GeneratedValue(strategy=SEQUENCE, generator="bookSeq") // reference to generator defined below

@SequenceGenerator(name="bookSeq", sequenceName="seq_book", initialValue = 5, allocationSize=10)

Long id;1

2

3

4

2

3

4

JPA id generators may be shared between entities. A @SequenceGenerator or @TableGenerator must have a name, and may be shared between multiple id attributes. This fits somewhat uncomfortably with the common practice of annotating the @Id attribute which makes use of the generator! | |

|---|---|

As you can see, JPA provides quite adequate support for the most common strategies for system-generated ids. However, the annotations themselves are a bit more intrusive than they should be, and there’s no well-defined way to extend this framework to support custom strategies for id generation. Nor may @GeneratedValue be used on a property not annotated @Id. Since custom id generation is a rather common requirement, Hibernate provides a very carefully-designed framework for user-defined Generators, which we’ll discuss in User-defined generators.

3.6. Natural keys as identifiers

Not every identifier attribute maps to a (system-generated) surrogate key. Primary keys which are meaningful to the user of the system are called natural keys.

When the primary key of a table is a natural key, we don’t annotate the identifier attribute @GeneratedValue, and it’s the responsibility of the application code to assign a value to the identifier attribute.

@Entity

class Book {

@Id

String isbn;

...

}1

2

3

4

5

6

7

2

3

4

5

6

7

Of particular interest are natural keys which comprise more than one database column, and such natural keys are called composite keys.

3.7. Composite identifiers

If your database uses composite keys, you’ll need more than one identifier attribute. There are two ways to map composite keys in JPA:

- using an

@IdClass, or - using an

@EmbeddedId.

Perhaps the most immediately-natural way to represent this in an entity class is with multiple fields annotated @Id, for example:

@Entity

@IdClass(BookId.class)

class Book {

Book() {}

@Id

String isbn;

@Id

int printing;

...

}1

2

3

4

5

6

7

8

9

10

11

12

13

2

3

4

5

6

7

8

9

10

11

12

13

But this approach comes with a problem: what object can we use to identify a Book and pass to methods like find() which accept an identifier?

The solution is to write a separate class with fields that match the identifier attributes of the entity. The @IdClass annotation of the Book entity identifies the id class to use for that entity:

class BookId {

String isbn;

int printing;

BookId() {}

BookId(String isbn, int printing) {

this.isbn = isbn;

this.printing = printing;

}

@Override

public boolean equals(Object other) {

if (other instanceof BookId) {

BookId bookId = (BookId) other;

return bookId.isbn.equals(isbn)

&& bookId.printing == printing;

}

else {

return false;

}

}

@Override

public int hashCode() {

return isbn.hashCode();

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

27

28

29

Every id class should override equals() and hashCode().

This is not our preferred approach. Instead, we recommend that the BookId class be declared as an @Embeddable type:

@Embeddable

class BookId {

String isbn;

int printing;

BookId() {}

BookId(String isbn, int printing) {

this.isbn = isbn;

this.printing = printing;

}

...

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

We’ll learn more about Embeddable objects below.

Now the entity class may reuse this definition using @EmbeddedId, and the @IdClass annotation is no longer required:

@Entity

class Book {

Book() {}

@EmbeddedId

BookId bookId;

...

}1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

This second approach eliminates some duplicated code.

Either way, we may now use BookId to obtain instances of Book:

Book book = session.find(Book.class, new BookId(isbn, printing));1

3.8. Version attributes

An entity may have an attribute which is used by Hibernate for optimistic lock checking. A version attribute is usually of type Integer, Short, Long, LocalDateTime, OffsetDateTime, ZonedDateTime, or Instant.

@Version

LocalDateTime lastUpdated;1

2

2

Version attributes are automatically assigned by Hibernate when an entity is made persistent, and automatically incremented or updated each time the entity is updated.

If an entity doesn’t have a version number, which often happens when mapping legacy data, we can still do optimistic locking. The @OptimisticLocking annotation lets us specify that optimistic locks should be checked by validating the values of ALL fields, or only the DIRTY fields of the entity. And the @OptimisticLock annotation lets us selectively exclude certain fields from optimistic locking. | |

|---|---|

The @Id and @Version attributes we’ve already seen are just specialized examples of basic attributes.

3.9. Natural id attributes

Even when an entity has a surrogate key, it should always be possible to write down a combination of fields which uniquely identifies an instance of the entity, from the point of view of the user of the system. This combination of fields is its natural key. Above, we considered the case where the natural key coincides with the primary key. Here, the natural key is a second unique key of the entity, distinct from its surrogate primary key.

| If you can’t identify a natural key, it might be a sign that you need to think more carefully about some aspect of your data model. If an entity doesn’t have a meaningful unique key, then it’s impossible to say what event or object it represents in the "real world" outside your program. | |

|---|---|

Since it’s extremely common to retrieve an entity based on its natural key, Hibernate has a way to mark the attributes of the entity which make up its natural key. Each attribute must be annotated @NaturalId.

@Entity

class Book {

Book() {}

@Id @GeneratedValue

Long id; // the system-generated surrogate key

@NaturalId

String isbn; // belongs to the natural key

@NaturalId

int printing; // also belongs to the natural key

...

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

2

3

4

5

6

7

8

9

10

11

12

13

14

15

Hibernate automatically generates a UNIQUE constraint on the columns mapped by the annotated fields.

Consider using the natural id attributes to implement equals() and hashCode(). | |

|---|---|

The payoff for doing this extra work, as we will see much later, is that we can take advantage of optimized natural id lookups that make use of the second-level cache.

Note that even when you’ve identified a natural key, we still recommend the use of a generated surrogate key in foreign keys, since this makes your data model much easier to change.

3.10. Basic attributes

A basic attribute of an entity is a field or property which maps to a single column of the associated database table. The JPA specification defines a quite limited set of basic types:

| Classification | Package | Types |

|---|---|---|

| Primitive types | boolean, int, double, etc | |

| Primitive wrappers | java.lang | Boolean, Integer, Double, etc |

| Strings | java.lang | String |

| Arbitrary-precision numeric types | java.math | BigInteger, BigDecimal |

| Date/time types | java.time | LocalDate, LocalTime, LocalDateTime, OffsetDateTime, Instant |

| Deprecated date/time types 💀 | java.util | Date, Calendar |

| Deprecated JDBC date/time types 💀 | java.sql | Date, Time, Timestamp |

| Binary and character arrays | byte[], char[] | |

| UUIDs | java.util | UUID |

| Enumerated types | Any enum | |

| Serializable types | Any type which implements java.io.Serializable |

We’re begging you to use types from the java.time package instead of anything which inherits java.util.Date. | |

|---|---|

| Serializing a Java object and storing its binary representation in the database is usually wrong. As we’ll soon see in Embeddable objects, Hibernate has much better ways to handle complex Java objects. | |

|---|---|

Hibernate slightly extends this list with the following types:

| Classification | Package | Types |

|---|---|---|

| Additional date/time types | java.time | Duration, ZoneId, ZoneOffset, Year, and even ZonedDateTime |

| JDBC LOB types | java.sql | Blob, Clob, NClob |

| Java class object | java.lang | Class |

| Miscellaneous types | java.util | Currency, URL, TimeZone |

The @Basic annotation explicitly specifies that an attribute is basic, but it’s often not needed, since attributes are assumed basic by default. On the other hand, if a non-primitively-typed attribute cannot be null, use of @Basic(optional=false) is highly recommended.

@Basic(optional=false) String firstName;

@Basic(optional=false) String lastName;

String middleName; // may be null1

2

3

2

3

Note that primitively-typed attributes are inferred NOT NULL by default.

How to make a column not null in JPA

There are two standard ways to add a NOT NULL constraint to a mapped column in JPA:

- using

@Basic(optional=false), or - using

@Column(nullable=false).

You might wonder what the difference is.

Well, it’s perhaps not obvious to a casual user of the JPA annotations, but they actually come in two "layers":

- annotations like

@Entity,@Id, and@Basicbelong to the logical layer, the subject of the current chapter—they specify the semantics of your Java domain model, whereas - annotations like

@Tableand@Columnbelong to the mapping layer, the topic of the next chapter—they specify how elements of the domain model map to objects in the relational database.

Information may be inferred from the logical layer down to the mapping layer, but is never inferred in the opposite direction.

Now, the @Column annotation, to whom we’ll be properly introduced a bit later, belongs to the mapping layer, and so its nullable member only affects schema generation (resulting in a not null constraint in the generated DDL). On the other hand, the @Basic annotation belongs to the logical layer, and so an attribute marked optional=false is checked by Hibernate before it even writes an entity to the database. Note that:

optional=falseimpliesnullable=false, butnullable=falsedoes not implyoptional=false.

Therefore, we prefer @Basic(optional=false) to @Column(nullable=false).

But wait! An even better solution is to use the @NotNull annotation from Bean Validation. Just add Hibernate Validator to your project build, as described in Optional dependencies. | |

|---|---|

3.11. Enumerated types

We included Java enums on the list above. An enumerated type is considered a sort of basic type, but since most databases don’t have a native ENUM type, JPA provides a special @Enumerated annotation to specify how the enumerated values should be represented in the database:

- by default, an enum is stored as an integer, the value of its

ordinal()member, but - if the attribute is annotated

@Enumerated(STRING), it will be stored as a string, the value of itsname()member.

//here, an ORDINAL encoding makes sense

@Enumerated

@Basic(optional=false)

DayOfWeek dayOfWeek;

//but usually, a STRING encoding is better

@Enumerated(EnumType.STRING)

@Basic(optional=false)

Status status;1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

In Hibernate 6, an enum annotated @Enumerated(STRING) is mapped to:

- a

VARCHARcolumn type with aCHECKconstraint on most databases, or - an

ENUMcolumn type on MySQL.

Any other enum is mapped to a TINYINT column with a CHECK constraint.

JPA picks the wrong default here. In most cases, storing an integer encoding of the enum value makes the relational data harder to interpret.Even considering DayOfWeek, the encoding to integers is ambiguous. If you check java.time.DayOfWeek, you’ll notice that SUNDAY is encoded as 6. But in the country I was born, SUNDAY is the first day of the week!So we prefer @Enumerated(STRING) for most enum attributes. | |

|---|---|

An interesting special case is PostgreSQL. Postgres supports named ENUM types, which must be declared using a DDL CREATE TYPE statement. Sadly, these ENUM types aren’t well-integrated with the language nor well-supported by the Postgres JDBC driver, so Hibernate doesn’t use them by default. But if you would like to use a named enumerated type on Postgres, just annotate your enum attribute like this:

@JdbcTypeCode(SqlTypes.NAMED_ENUM)

@Basic(optional=false)

Status status;1

2

3

2

3

The limited set of pre-defined basic attribute types can be stretched a bit further by supplying a converter.

3.12. Converters

A JPA AttributeConverter is responsible for:

- converting a given Java type to one of the types listed above, and/or

- perform any other sort of pre- and post-processing you might need to perform on a basic attribute value before writing and reading it to or from the database.

Converters substantially widen the set of attribute types that can be handled by JPA.

There are two ways to apply a converter:

- the

@Convertannotation applies anAttributeConverterto a particular entity attribute, or - the

@Converterannotation (or, alternatively, the@ConverterRegistrationannotation) registers anAttributeConverterfor automatic application to all attributes of a given type.

For example, the following converter will be automatically applied to any attribute of type BitSet, and takes care of persisting the BitSet to a column of type varbinary:

@Converter(autoApply = true)

public static class EnumSetConverter implements AttributeConverter<EnumSet<DayOfWeek>,Integer> {

@Override

public Integer convertToDatabaseColumn(EnumSet<DayOfWeek> enumSet) {

int encoded = 0;

var values = DayOfWeek.values();

for (int i = 0; i<values.length; i++) {

if (enumSet.contains(values[i])) {

encoded |= 1<<i;

}

}

return encoded;

}

@Override

public EnumSet<DayOfWeek> convertToEntityAttribute(Integer encoded) {

var set = EnumSet.noneOf(DayOfWeek.class);

var values = DayOfWeek.values();

for (int i = 0; i<values.length; i++) {

if (((1<<i) & encoded) != 0) {

set.add(values[i]);

}

}

return set;

}

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

22

23

24

25

26

On the other hand, if we don’t set autoapply=true, then we must explicitly apply the converter using the @Convert annotation:

@Convert(converter = BitSetConverter.class)

@Basic(optional = false)

BitSet bitset;1

2

3

2

3

All this is nice, but it probably won’t surprise you that Hibernate goes beyond what is required by JPA.

3.13. Compositional basic types

Hibernate considers a "basic type" to be formed by the marriage of two objects:

- a

JavaType, which models the semantics of a certain Java class, and - a

JdbcType, representing a SQL type which is understood by JDBC.

When mapping a basic attribute, we may explicitly specify a JavaType, a JdbcType, or both.

JavaType

An instance of org.hibernate.type.descriptor.java.JavaType represents a particular Java class. It’s able to:

- compare instances of the class to determine if an attribute of that class type is dirty (modified),

- produce a useful hash code for an instance of the class,

- coerce values to other types, and, in particular,

- convert an instance of the class to one of several other equivalent Java representations at the request of its partner

JdbcType.

For example, IntegerJavaType knows how to convert an Integer or int value to the types Long, BigInteger, and String, among others.

We may explicitly specify a Java type using the @JavaType annotation, but for the built-in JavaTypes this is never necessary.

@JavaType(LongJavaType.class) // not needed, this is the default JavaType for long

long currentTimeMillis;1

2

2

For a user-written JavaType, the annotation is more useful:

@JavaType(BitSetJavaType.class)

BitSet bitSet;1

2

2

Alternatively, the @JavaTypeRegistration annotation may be used to register BitSetJavaType as the default JavaType for BitSet.

JdbcType

A org.hibernate.type.descriptor.jdbc.JdbcType is able to read and write a single Java type from and to JDBC.

For example, VarcharJdbcType takes care of:

- writing Java strings to JDBC

PreparedStatements by callingsetString(), and - reading Java strings from JDBC

ResultSets usinggetString().

By pairing LongJavaType with VarcharJdbcType in holy matrimony, we produce a basic type which maps Longs and primitive longss to the SQL type VARCHAR.

We may explicitly specify a JDBC type using the @JdbcType annotation.

@JdbcType(VarcharJdbcType.class)

long currentTimeMillis;1

2

2

Alternatively, we may specify a JDBC type code:

@JdbcTypeCode(Types.VARCHAR)

long currentTimeMillis;1

2

2

The @JdbcTypeRegistration annotation may be used to register a user-written JdbcType as the default for a given SQL type code.

JDBC types and JDBC type codes

The types defined by the JDBC specification are enumerated by the integer type codes in the class java.sql.Types. Each JDBC type is an abstraction of a commonly-available type in SQL. For example, Types.VARCHAR represents the SQL type VARCHAR (or VARCHAR2 on Oracle).

Since Hibernate understand more SQL types than JDBC, there’s an extended list of integer type codes in the class org.hibernate.type.SqlTypes. For example, SqlTypes.GEOMETRY represents the spatial data type GEOMETRY.

AttributeConverter

If a given JavaType doesn’t know how to convert its instances to the type required by its partner JdbcType, we must help it out by providing a JPA AttributeConverter to perform the conversion.

For example, to form a basic type using LongJavaType and TimestampJdbcType, we would provide an AttributeConverter<Long,Timestamp>.

@JdbcType(TimestampJdbcType.class)

@Convert(converter = LongToTimestampConverter.class)

long currentTimeMillis;1

2

3

2

3

Let’s abandon our analogy right here, before we start calling this basic type a "throuple".

3.14. Embeddable objects

An embeddable object is a Java class whose state maps to multiple columns of a table, but which doesn’t have its own persistent identity. That is, it’s a class with mapped attributes, but no @Id attribute.

An embeddable object can only be made persistent by assigning it to the attribute of an entity. Since the embeddable object does not have its own persistent identity, its lifecycle with respect to persistence is completely determined by the lifecycle of the entity to which it belongs.

An embeddable class must be annotated @Embeddable instead of @Entity.

@Embeddable

class Name {

@Basic(optional=false)

String firstName;

@Basic(optional=false)

String lastName;

String middleName;

Name() {}

Name(String firstName, String middleName, String lastName) {

this.firstName = firstName;

this.middleName = middleName;

this.lastName = lastName;

}

...

}1

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

2

3

4

5

6

7

8

9

10

11

12

13

14

15

16

17

18

19

20

21

An embeddable class must satisfy the same requirements that entity classes satisfy, with the exception that an embeddable class has no @Id attribute. In particular, it must have a constructor with no parameters.

Alternatively, an embeddable type may be defined as a Java record type:

@Embeddable

record Name(String firstName, String middleName, String lastName) {}1

2

2

In this case, the requirement for a constructor with no parameters is relaxed.

Unfortunately, as of May 2023, Java record types still cannot be used as @EmbeddedIds. | |

|---|---|

We may now use our Name class (or record) as the type of an entity attribute:

@Entity

class Author {

@Id @GeneratedValue

Long id;

Name name;

...

}1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

Embeddable types can be nested. That is, an @Embeddable class may have an attribute whose type is itself a different @Embeddable class.

JPA provides an @Embedded annotation to identify an attribute of an entity that refers to an embeddable type. This annotation is completely optional, and so we don’t usually use it. | |

|---|---|

另一方面,对可嵌入类型的引用永远不是多态的。一个@Embeddable类F可以继承第二个@Embeddable类E,但 type 的属性E将始终引用该具体类的实例E,而不是 的实例F。

通常,可嵌入类型以“扁平”格式存储。它们的属性映射其父实体的表的列。稍后,在将可嵌入类型映射到 UDT 或 JSON 中,我们将看到几个不同的选项。

可嵌入类型的属性表示具有持久标识的 Java 对象与不具有持久标识的 Java 对象之间的关系。我们可以将其视为整体/部分关系。可嵌入对象属于实体,不能与其他实体实例共享。并且只要其父实体存在,它就存在。

接下来我们将讨论一种不同类型的关系:Java 对象之间的关系,每个对象都有自己独特的持久标识和持久生命周期。

3.15。协会

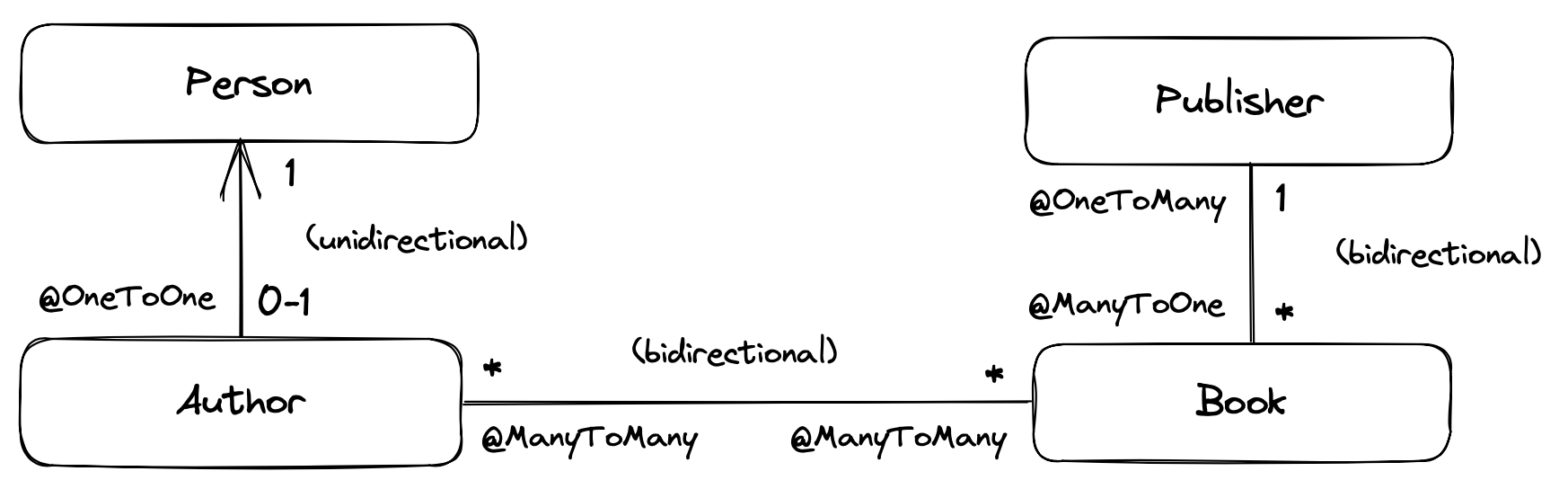

关联是实体之间的关系。我们通常根据关联的多样性对其进行分类。如果E和F都是实体类,那么:

- 一对一关联最多将一个唯一实例与的

E最多一个唯一实例相关联F, - 多对一关联将零个或多个 的实例

E与 的唯一实例相关联F,并且 - 多对多关联将零个或多个 的实例与零个或多个的

E实例相关F。

实体类之间的关联可以是:

- 单向,可从

E导航至F,但不能从F导航至E,或 - 双向,并且可以在任一方向上导航。

在此示例数据模型中,我们可以看到可能的关联类型:

精明的观察者可能会注意到,我们以单向一对一关联的形式呈现的关系可以在 Java 中使用子类型合理地表示。这是很正常的。一对一关联是我们在完全标准化的关系模型中实现子类型的常用方式。这与JOINED 继承映射策略有关。 | |

|---|---|

映射关联有 3 个注释:@ManyToOne、@OneToMany和@ManyToMany。他们共享一些共同的注释成员:

| 成员 | 解释 | 默认值 |

|---|---|---|

cascade | 应级联到关联实体的持久化操作;CascadeTypes的列表 | {} |

fetch | 关联是急切 获取还是可以代理 | LAZY对于@OneToMany和@ManyToMany``EAGER为了@ManyToOne💀💀💀 |

targetEntity | 关联的实体类 | 由属性类型声明确定 |

optional | 对于@ManyToOneor@OneToOne关联,该关联是否可以null | true |

mappedBy | 对于双向关联,映射关联的关联实体的属性 | 默认情况下,假定关联是单向的 |

当我们考虑各种类型的关联映射时,我们将解释这些成员的作用。

让我们从最常见的关联多重性开始。

3.16。多对一

多对一关联是我们可以想象的最基本的关联类型。它完全自然地映射到数据库中的外键。域模型中的几乎所有关联都将采用这种形式。

| 稍后,我们将了解如何将多对一关联映射到关联表。 | |

|---|---|

该@ManyToOne注释标记了关联的“对一”一侧,因此单向多对一关联如下所示:

class Book {

@Id @GeneratedValue

Long id;

@ManyToOne(fetch=LAZY)

Publisher publisher;

...

}1

2

3

4

5

6

7

8

9

2

3

4

5

6

7

8

9

这里,Book表有一个外键列,保存关联的标识符Publisher。

JPA 的一个非常不幸的缺陷是@ManyToOne默认情况下会急切地获取关联。这几乎从来都不是我们想要的。几乎所有协会都应该是懒惰的。唯一有意义的情况是,如果我们认为在二级缓存中找到关联对象的可能性fetch=EAGER总是很高。每当情况并非如此时,请记住显式指定.fetch=LAZY | |

|---|---|

大多数时候,我们希望能够轻松地在两个方向上导航我们的关联。我们确实需要一种方法来获取给Publisher定的Book,但我们也希望能够获取Book属于给定发布者的所有 s 。

为了使这种关联是双向的,我们需要向类添加一个集合值属性Publisher,并对其进行注释@OneToMany。

Hibernate 需要在运行时代理未获取的关联。因此,多值端必须使用像Setor 这样的接口类型来声明,而不能使用像orList这样的具体类型。HashSet``ArrayList | |

|---|---|

为了清楚地表明这是一个双向关联,并重用实体中已指定的任何映射信息Book,我们必须使用mappedBy注释成员来引用回Book.publisher。

@Entity

class Publisher {

@Id @GeneratedValue

Long id;

@OneToMany(mappedBy="publisher")

Set<Book> books;

...

}1

2

3

4

5

6

7

8

9

10

2

3

4

5

6

7

8

9

10

该Publisher.books字段称为关联的无主端。

现在,我们非常讨厌mappedBy对关联拥有方的字符串类型引用。值得庆幸的是,元模型生成器为我们提供了一种使其类型更加安全的方法:

@OneToMany(mappedBy=Book_.PUBLISHER) // get used to doing it this way!

Set<Book> books;1

2

2

We’re going to use this approach for the rest of the Introduction.

To modify a bidirectional association, we must change the owning side.

Changes made to the unowned side of an association are never synchronized to the database. If we desire to change an association in the database, we must change it from the owning side. Here, we must set Book.publisher.In fact, it’s often necessary to change both sides of a bidirectional association. For example, if the collection Publisher.books was stored in the second-level cache, we must also modify the collection, to ensure that the second-level cache remains synchronized with the database. | |

|---|---|

That said, it’s not a hard requirement to update the unowned side, at least if you’re sure you know what you’re doing.

In principle Hibernate does allow you to have a unidirectional one-to-many, that is, a @OneToMany with no matching @ManyToOne on the other side. In practice, this mapping is unnatural, and just doesn’t work very well. Avoid it. | |

|---|---|

Here we’ve used Set as the type of the collection, but Hibernate also allows the use of List or Collection here, with almost no difference in semantics. In particular, the List may not contain duplicate elements, and its order will not be persistent.

@OneToMany(mappedBy=Book_.PUBLISHER)

Collection<Book> books;1

2

2

We’ll see how to map a collection with a persistent order much later.

Set, List, or Collection?

A one-to-many association mapped to a foreign key can never contain duplicate elements, so Set seems like the most semantically correct Java collection type to use here, and so that’s the conventional practice in the Hibernate community.

The catch associated with using a set is that we must carefully ensure that Book has a high-quality implementation of equals() and hashCode(). Now, that’s not necessarily a bad thing, since a quality equals() is independently useful.

But what if we used Collection or List instead? Then our code would be much less sensitive to how equals() and hashCode() were implemented.

In the past, we were perhaps too dogmatic in recommending the use of Set. Now? I guess we’re happy to let you guys decide. In hindsight, we could have done more to make clear that this was always a viable option.

3.17. One-to-one (first way)

The simplest sort of one-to-one association is almost exactly like a @ManyToOne association, except that it maps to a foreign key column with a UNIQUE constraint.

| Later, we’ll see how to map a one-to-one association to an association table. | |

|---|---|

A one-to-one association must be annotated @OneToOne:

@Entity

class Author {

@Id @GeneratedValue

Long id;

@OneToOne(optional=false, fetch=LAZY)

Person author;

...

}1

2

3

4

5

6

7

8

9

10

2

3

4

5

6

7

8

9

10

Here, the Author table has a foreign key column holding the identifier of the associated Publisher.

A one-to-one association often models a "type of" relationship. In our example, an Author is a type of Person. An alternative—and often more natural—way to represent "type of" relationships in Java is via entity class inheritance. | |

|---|---|

We can make this association bidirectional by adding a reference back to the Author in the Person entity:

@Entity

class Person {

@Id @GeneratedValue

Long id;

@OneToOne(mappedBy = Author_.PERSON)

Author author;

...

}1

2

3

4

5

6

7

8

9

10

2

3

4

5

6

7

8

9

10

Person.author is the unowned side, because it’s the side marked mappedBy.

Lazy fetching for one-to-one associations

Notice that we did not declare the unowned end of the association fetch=LAZY. That’s because:

- not every

Personhas an associatedAuthor, and - the foreign key is held in the table mapped by

Author, not in the table mapped byPerson.

Therefore, Hibernate can’t tell if the reference from Person to Author is null without fetching the associated Author.

On the other hand, if every Person was an Author, that is, if the association were non-optional, we would not have to consider the possibility of null references, and we would map it like this:

@OneToOne(optional=false, mappedBy = Author_.PERSON, fetch=LAZY)

Author author;1

2

2

This is not the only sort of one-to-one association.

3.18. One-to-one (second way)

An arguably more elegant way to represent such a relationship is to share a primary key between the two tables.

To use this approach, the Author class must be annotated like this:

@Entity

class Author {

@Id

Long id;

@OneToOne(optional=false, fetch=LAZY)

@MapsId

Person author;

...

}1

2

3

4

5

6

7

8

9

10

11

2

3

4

5

6

7

8

9

10

11

Notice that, compared with the previous mapping:

- the

@Idattribute is no longer a@GeneratedValueand, - instead, the

authorassociation is annotated@MapsId.

This lets Hibernate know that the association to Person is the source of primary key values for Author.

Here, there’s no extra foreign key column in the Author table, since the id column holds the identifier of Person. That is, the primary key of the Author table does double duty as the foreign key referring to the Person table.

The Person class doesn’t change. If the association is bidirectional, we annotate the unowned side @OneToOne(mappedBy = Author_.PERSON) just as before.

3.19. Many-to-many

A unidirectional many-to-many association is represented as a collection-valued attribute. It always maps to a separate association table in the database.

It tends to happen that a many-to-many association eventually turns out to be an entity in disguise.

Suppose we start with a nice clean many-to-many association between Author and Book. Later on, it’s quite likely that we’ll discover some additional information which comes attached to the association, so that the association table needs some extra columns.例如,假设我们需要报告每位作者对一本书的贡献百分比。该信息自然属于关联表。我们不能轻易地将其存储为 的属性Book,也不能将其存储为 的属性Author。当这种情况发生时,我们需要改变我们的Java模型,通常引入一个新的实体类来直接映射关联表。在我们的示例中,我们可以将此实体称为BookAuthorship,并且它@OneToMany与Author和Book以及contribution属性都有关联。@ManyToMany我们可以通过从一开始就避免使用权利来避免此类“发现”造成的破坏。使用中间实体来表示每个(或至少几乎每个)逻辑多对多关联几乎没有什么缺点。 | |

|---|---|

多对多关联必须注释@ManyToMany:

@Entity

class Book {

@Id @GeneratedValue

Long id;

@ManyToMany

Set<Author> authors;

...

}1

2

3

4

5

6

7

8

9

10